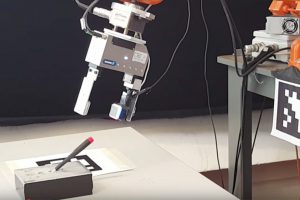

فناوری GelSight به ربات ها اجازه می دهد تا سختی اجسام را اندازه گیری کرده و ابزارهای کوچک را دستکاری کنند.یک سنسور GelSight متصل بهگیربکس ربات به ربات این امکان رامی دهد تا دقیقاً مشخص کند که درکجا یک پیچ گوشتی کوچک را گرفته است ، آن را از در خارج کرده و دوباره در شکاف قرار می دهد ، حتی زمانی که گیربکس پیچ گوشتی را از دوربین ربات نمایش می دهد. هشت سال پیش، گروه تحقیقاتی تد آدلسون در آزمایشگاه علوم رایانه و هوش مصنوعی MIT CSAIL از فناوری حسگر جدیدی به نام GelSight رونمایی کردند که از تماس فیزیکی با یک جسم برای تهیه یک نقشه سه بعدی بسیار دقیق از سطح آن استفاده می کند. اکنون، با نصب سنسورهای GelSight بر روی دسته های بازوی رباتیک، دو تیم MIT حساسیت و مهارت بیشتری به ربات ها داده اند.

محققان هفتهگذشته کار خود را در دو مقاله در کنفرانس بین المللی رباتیک و اتوماسیون ارائه کردند.در یک مقاله ، گروه آدلسون با استفاده از داده های سنسور GelSight یک ربات را قادر می سازد تا سختی سطوح لمس شده را قضاوت کند – این یکتوانایی اساسی برای ربات های خانگی برای رسیدگی به اشیاء روزمره است.در طرف دیگر ، گروه حرکت رباتان Russ Tedrake در CSAIL از سنسورهای GelSightاستفاده می کند تا یک ربات بتواند اجسام کوچکتر را نسبت بهآنچه قبلاً امکان پذیر بود ، دستکاری کند.حسگر GelSight به نوعی راه حلی با فناوری پایین برای حل مشکل است. این شامل یک بلوک لاستیک شفاف – “ژل” نام آن است – یک صورت آن با رنگ فلزی پوشیده شده است. هنگامی که صورت روکش شده بر روی یک جسم فشرده می شود ، با شکل آن مطابقت دارد.رنگ فلزی باعث می شود سطح جسم منعکس شود ، بنابراین هندسه آن برای الگوریتم های دید رایانه بسیار آسان تر است. سه سنسور رنگی و یکدوربین واحد بر روی سنسور روبروی روکش بلوک لاستیکی نصب شده است.آدلسون ، جان توضیح می دهد: سیستم دارای چراغ های رنگی در زوایای مختلف است و سپس دارای یک ماده بازتابنده است و با مشاهده رنگ ها ،کامپیوتر می تواند شکل سه بعدی آن چیز را بفهمد. و دوروتی ویلسون پروفسور علوم بینایی در گروه علوم مغزی و شناختی.در هر دو آزمایش ، یکسنسور GelSight در یک طرف گیرنده رباتیک نصب شده بود ، دستگاه تا حدی شبیه سر یک گیره است ، اما دارای سطوح صاف و محکم به جای نوکهای نوک تیز بود.

نقاط تماس

برای یک ربات خودمختار ، سنجش نرمی یا سختی اجسام نه تنها برای تصمیم گیری در مورد اینکه کجا و چگونه سخت است بلکه چگونه رفتار می کندهنگام حرکت ، روی هم چیدن یا روی سطوح مختلف رفتار می کند ، ضروری است. حس لامسه همچنین می تواند به ربات ها در تشخیص اجسامشبیه به هم کمک کند.در کارهای قبلی ، ربات ها سعی کرده اند سختی اجسام را با قرار دادن آنها بر روی سطح صاف و فشار دادن آنها به آرامی برای دیدن مقدار آنها، ارزیابی کنند. اما این اصلی ترین روش سنجش سختی انسان نیست. به نظر میرسد قضاوت های ما بر اساس میزان تغییر ناحیه تماس بین شی و انگشتان مابا فشار دادن آن است. اجسام نرمتر بیشتر صاف می شوند و سطح تماس را افزایش می دهند.محققان MITهمین رویکرد را اتخاذ کردند. ونژن یوان ، دانشجوی کارشناسی ارشد مهندسی مکانیک و اولین نویسنده مقاله از گروه آدلسون ، از قالبهای شیرینی پزی برای ایجاد ۴۰۰ گروه از اشیاء سیلیکونی با ۱۶ شی در هر گروه استفاده کرد. در هر گروه، اجسام دارای اشکال یکسان اما درجه سختی متفاوت بودند ، که یوان آنها را با استفاده از مقیاس استاندارد صنعتی اندازه گیری کرد.سپس او یک سنسور GelSight را به صورت دستی بر روی هر شی فشار داد و نحوه تغییر الگوی تماس را در طول زمان ثبت کرد و اساساً یک فیلم کوتاهبرای هر شی تولید کرد. او برایاستانداردسازی قالبداده و کنترل اندازه داده ها ، از هر فیلم پنج فریم ، به طور مساوی در زمان ، استخراج کرد که تغییر شکل جسم تحتفشار را توصیف می کرد.سرانجام ، او داده ها را به یک شبکه عصبی هدایت کرد، که به طور خودکار به دنبال ارتباط بین تغییرات الگوهایتماس و اندازه گیری سختی بود. سیستم حاصله فریم های ویدئویی را به عنوان ورودی گرفته و نمرات سختی را با دقت بسیار بالا تولید میکند. یوان همچنین مجموعه ای از آزمایشهای غیررسمی را انجام داد که در آن افراد انسانی میوه ها و سبزیجات را لمس کرده و آنها را براساس سختی طبقه بندی کردند. در هر نمونه ، رباتمجهز به GelSight در همان رتبه بندی قرار گرفت.یوان با دو مشاور پایان نامه خود ، آدلسون و ماندایام سرینیوسان ، دانشمند ارشد تحقیقاتی در گروه مهندسی مکانیک، همراه است.Chenzhuo Zhu، دانشجوی کارشناسی از دانشگاه Tsinghua که تابستان گذشته از گروهAdelson دیدن کرد. و اندرو اوونز، که دکترایخود را در رشته مهندسی برق وعلوم کامپیوتر در MIT انجام داد و اکنون یک فوق لیسانس در دانشگاه کالیفرنیا در برکلی است.

منبع : https://news.mit.edu/